Dans les pages des journaux économiques on associe en général la technologie, celle que l’on trouve dans les hôpitaux, dans nos moyens de transport et dans nos outils de communication, à l’idée de bien. Ou à défaut à l’idée de progrès. Or il faut rappeler, comme le constate Alexei Grinbaum, un chercheur au Commissariat à l’énergie atomique, qu’il n’en va pas toujours ainsi : « des assistants domestiques se font délateurs, des voitures autonomes soudain tuent, des agents conversationnels injurient leurs interlocuteurs. Des systèmes informatiques participent aux conflits humains, et les provoquent parfois. » En bref, les technologies peuvent provoquer le bien autant que susciter le mal : « casser un bras, provoquer un accident, nous injurier ou nous donner de fâcheux conseils » (p. 81).

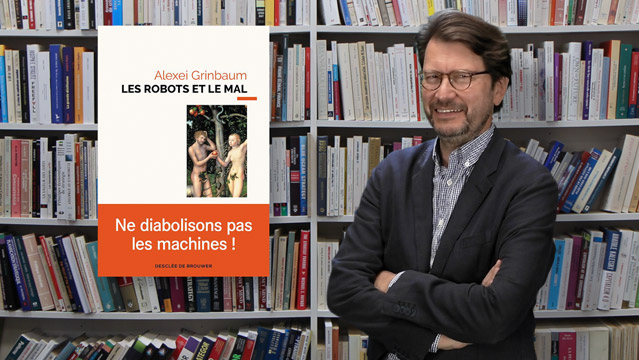

Le mal et les robots, c’est justement le titre qu’il donne à son dernier essai publié chez Desclée de Brouwer qui tente de poursuivre le travail réalisé par l’Institut du futur de l’humanité de l’Université d’Oxford consacré à « l’usage malicieux de l’intelligence artificielle : ». Ce rapport, d’ailleurs disponible en ligne gratuitement, mettait en évidence les vulnérabilités des systèmes informatiques et la nécessité de repenser préventivement notre sécurité tout à la fois digitale, physique et politique. L’auteur relève d’ailleurs que le mot « malveillant » constitue un aveu de la part des rédacteurs du rapport : tel le « malin génie » chez Descartes, l’usage de ce mot malicious en dit long sur les risques de violence contenus dans l’utilisation de nos machines, smartphones ou assistants personnels dits « intelligents ». Et Grinbaum de proposer alors trois thèses susceptibles d’éclairer notre rapport à ces outils:

-La première consiste à rappeler que les notions de « bien » et « mal » sont en soi étrangères aux robots quels qu’ils soient. Si les machines produisent du « mal » c’est en parfaite innocence pourrait-on dire, ou plutôt en parfaite ignorance. En ce sens les machines ne font que produire des données abstraites et des codes qui certes améliorent la performance de certains processus industriels, mais sans avoir la faculté d’en appréhender le but ultime.

-thèse numéro deux : les machines ne méritent pas d’être accusées de quoi que se soit car elle ne sont pas un sujet de droit. Le droit et l’éthique sont justement ce qui nous caractérisent en tant qu’êtres humains et les machines ne doivent, ni ne peuvent en réalité, se substituer à nous pour faire des choix moraux.

-enfin, le troisième élément du livre découle des deux premiers : seul le recours au hasard, c’est-à-dire au-delà du bien et du mal, pourrait émanciper la machine des choix qui sont en dernier appel les nôtres. Ce recours à l’aléatoire est finalement la seule manière de rendre à César ce qui lui appartient, de rendre aux hommes les choix éthiques que seuls ils sont mesure de faire.

La solution proposée par Grinbaum pourrait ici choquer en ce qu’elle privilégie le hasard sur la transparence, alors que celle-ci est exigée de plus en plus aujourd’hui par les utilisateurs eux-mêmes. Mais il prend justement l’exemple de la société Microsoft qui s’était engagée à faire œuvre de transparence pure et parfaite dans la traçabilité des données liées à l’intelligence artificielle avant de se raviser pour constater, comme l’avoue finalement la CNIL elle-même, qu’« il s’agit d’un désir inatteignable par excellence. » (p. 123). Pour s’en expliquer il écrit que les processus de deep learning, d’apprentissage permanent des machines, sont impropres à se laisser représenter clairement par une intelligence humaine.

En conclusion, cette réflexion nous incite à s’interroger sur l'espace grandissant, que notait déjà Gunther Anders dans les années 50, qui existe entre les multiples possibilités de l’intelligence des machines et les limites de nos capacités de raisonnement. Et doit donc nous inciter à mettre au premier rang de nos agendas la définition des valeurs que nous souhaitons défendre avec l’utilisation de ces outils, car c’est là que gît le propre de notre responsabilité. En ce sens, la phrase de Grinbaum qu’il faudrait méditer au sein des organisations désireuses d’utiliser les possibilités offertes par l’IA, mais aussi par les écoles d’ingénieurs et de management qui forment leurs futurs chefs de projet, serait alors la suivante. Elle figure page 34 : « Tout projet est réfléchi avant d’être réalisé : (car) c’est pendant ce temps de réflexion que l’éthique prend le pouvoir ».

Publié le jeudi 5 décembre 2019 .  4 min. 10

4 min. 10

D'APRÈS LE LIVRE :

|

Les robots et le mal

|

Les dernières vidéos

Idées, débats

Les dernières vidéos

de Ghislain Deslandes

LES + RÉCENTES

LES INCONTOURNABLES